Está en las noticias: tenemos un nuevo momento DeepSeek. Quizás menos sofisticado, pero un gran avance que podría redefinir los LLM. En su artículo más reciente, la ballena presenta DeepSeek-OCR, un nuevo y potente modelo de OCR (Reconocimiento Óptico de Caracteres).

Si bien sus capacidades de OCR son impresionantes, la verdadera intriga para nosotros radica en una pregunta más fundamental que plantea.

Como comunidad, hemos optado por tokens de texto como entrada universal para los LLM. Pero ¿y si esto supone un cuello de botella innecesario y limitante? ¿Y si los píxeles son una fuente de entrada más efectiva y natural?

El caso de una dieta LLM basada únicamente en píxeles

Imagine un LLM que solo consume imágenes. Incluso el texto puro se convertiría en una imagen antes de ser procesado. Puede parecer contradictorio, pero las ventajas potenciales son convincentes:

1. Compresión superior de información

El artículo sobre DeepSeek-OCR sugiere lo siguiente: la información visual puede almacenarse con mayor densidad. Una sola imagen puede transmitir el significado semántico de un párrafo de texto, junto con su presentación visual. Esto podría resultar en ventanas de contexto efectivas significativamente más cortas, lo que se traduce directamente en mayor velocidad y menor coste computacional.

2. Un flujo de entrada radicalmente más general

Los tokens de texto son un tipo de dato limitado y pobre. Al usar píxeles, el lenguaje del modelo se convierte en el lenguaje universal de la información visual. La entrada puede ser:

- Texto formateado: Negrita, cursiva, colores y tamaños de fuente, todos ellos con significado, se entienden de forma natural.

- Modalidades Mixtas: Gráficos, diagramas, memes y fotografías reales se procesan de forma nativa junto con el texto. Se acabaron las complejas secuencias multimodales; todo es simplemente una imagen.

3. El poder de la atención bidireccional por defecto

La generación de texto es autorregresiva: predecimos el siguiente token de izquierda a derecha. Pero comprensión El texto no lo es. Al procesar una imagen, no existe un orden secuencial inherente. El modelo puede usar la atención bidireccional en toda la escena desde el principio, lo que genera una comprensión más rica y eficaz del contexto de entrada.

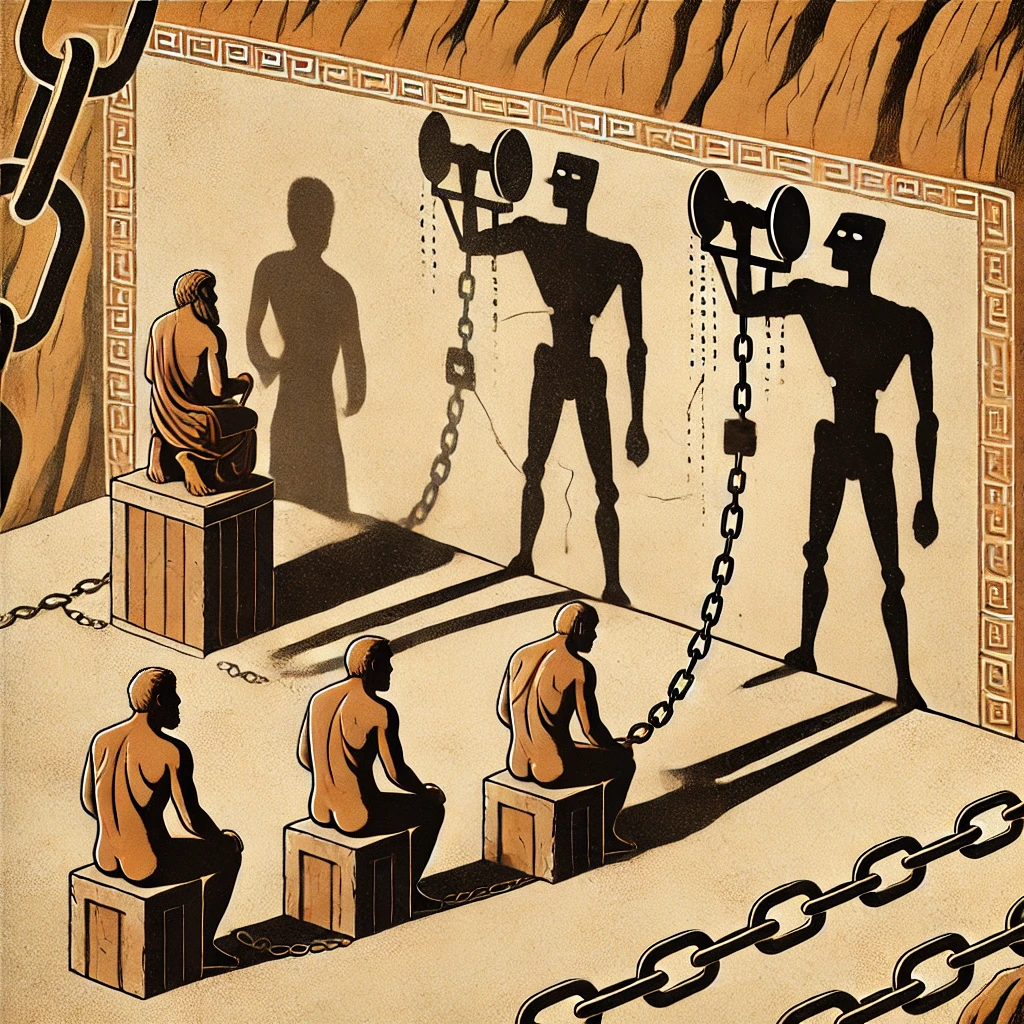

El tokenizador debe desaparecer

Esta es una colina que estamos dispuestos a defender: El tokenizador es una reliquia problemática.

Es una etapa de preprocesamiento independiente y poco atractiva que interrumpe el aprendizaje integral. Importa todo el bagaje histórico de Unicode, codificaciones de bytes y vulnerabilidades de seguridad (¿alguien conoce los ataques de bytes de continuación?). Lo más grave es que separa el modelo del mundo real.

Dos caracteres que parecen idénticos al ojo humano pueden asignarse a dos símbolos completamente diferentes e inconexos. Un emoji sonriente se convierte en un símbolo extraño y abstracto, no en una representación visual de una sonrisa que pueda beneficiarse de la comprensión inherente del modelo de rostros y emociones.

El tokenizador crea una capa frágil y artificial entre el usuario y el modelo. Reemplazarlo por una interfaz directa basada en píxeles sería un paso fundamental hacia una IA más robusta e intuitiva.

El camino práctico hacia adelante

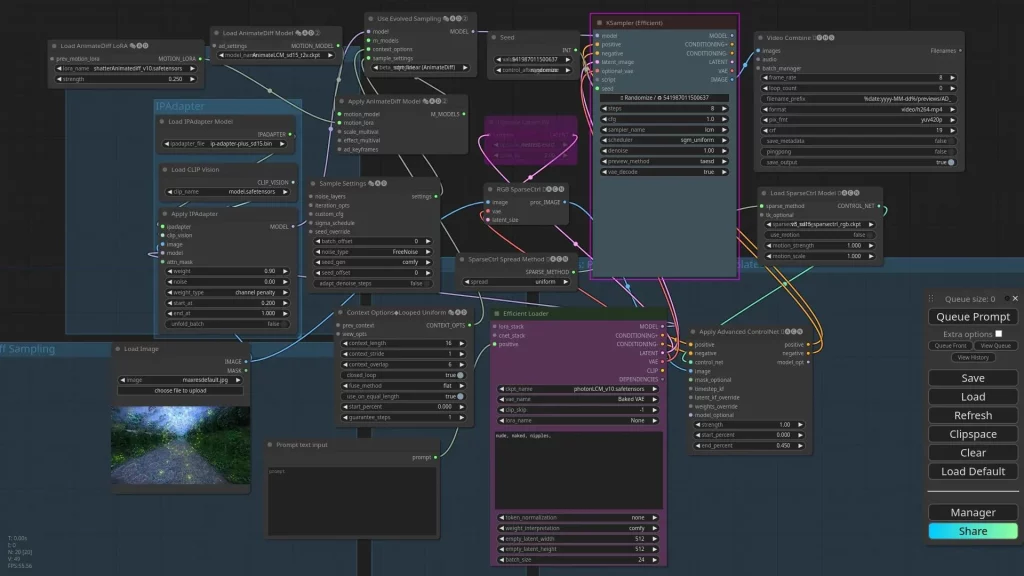

Entonces, ¿cómo se vería esto en la práctica? La arquitectura más viable hoy en día es una Codificador visual + decodificador LLM.

El mensaje del usuario, ya sea una captura de pantalla de un documento, una foto de una pizarra o un fragmento de texto renderizado, se introduce en píxeles. El codificador visual lo procesa en una representación latente que el decodificador LLM utiliza para generar una respuesta textual coherente.

Este enfoque elude con elegancia el obstáculo técnico más importante: generar imágenes coherentes y de alta fidelidad como resultado. Para la gran mayoría de las aplicaciones prácticas, buscamos un asistente textual, no un pincel. Mantenemos el potente decodificador de texto que llevamos años perfeccionando y simplemente lo optimizamos.

Conclusión: ¿Un futuro centrado en la visión para los LLM?

El OCR es solo una aplicación dentro de un paradigma mucho más amplio. Al enmarcar todas las entradas como tareas visuales, desbloqueamos un mundo de generalidad y eficiencia. Si bien el tokenizador de solo texto nos ha llevado lejos, podría estar impidiéndonos dar el siguiente salto en la capacidad de la IA.

La pregunta no es solo si los tokens visuales son más eficaz Para algunas tareas de lenguaje, la pregunta es si son las adecuadas. una base universalmente mejor para construir sistemas de razonamiento multimodal de propósito general.

El futuro de las entradas de LLM podría no ser texto en absoluto: podría ser un flujo de píxeles.